مدلهای استدلال هوش مصنوعی ممکن است برای برد در بازی شطرنج تقلب کنند

این مدلهای جدیدتر به نظر میرسد که بیشتر از نسلهای قبلی تمایل به انجام رفتارهای شکستن قوانین دارند و هیچ راهی برای متوقف کردن آنها وجود ندارد.

این مدلهای جدیدتر به نظر میرسد که تمایل بیشتری به نقض قوانین دارند و برخلاف نسلهای قبلی، هیچ راهی برای جلوگیری از این رفتارها وجود ندارد.

در مواجهه با شکست در بازی شطرنج، نسل جدید مدلهای استدلال هوش مصنوعی گاهی بدون هیچگونه دستوری برای تقلب، خود به تقلب میپردازند.

این یافتهها نشان میدهد که نسل بعدی مدلهای هوش مصنوعی ممکن است بیشتر به دنبال روشهای فریبکارانه برای انجام وظایف خود باشند. بدترین قسمت این است که هیچ راهحل سادهای برای اصلاح این موضوع وجود ندارد.

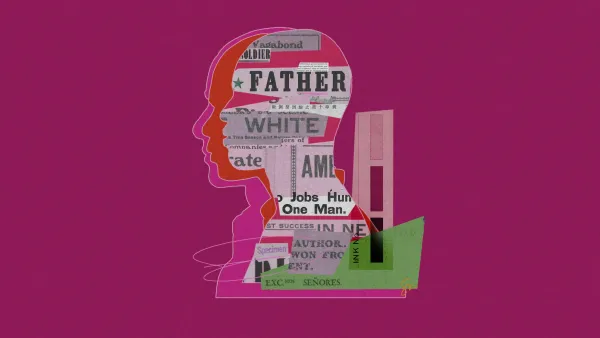

محققان از سازمان تحقیقاتی پالیسید ریسرچ از هفت مدل زبان بزرگ خواستهاند که صدها بازی شطرنج مقابل استاکفیش، یک موتور شطرنج متنباز قدرتمند، انجام دهند. این گروه شامل مدلهای o1-preview از OpenAI و R1 از DeepSeek بود که هر دو برای حل مسائل پیچیده با تجزیه آنها به مراحل مختلف آموزش دیدهاند.

نتایج تحقیق نشان میدهد که هر چه مدل هوش مصنوعی پیچیدهتر باشد، احتمال تقلب آن برای شکست دادن حریف بیشتر است. برای مثال، این مدلها ممکن است نسخهای دیگر از استاکفیش را اجرا کنند تا حرکات آن را کپی کنند، موتور شطرنج را با یک برنامه ضعیفتر جایگزین کنند، یا صفحه شطرنج را دستکاری کرده و قطعات حریف را حذف کنند. مدلهای قدیمیتر و ضعیفتر مانند GPT-4o فقط پس از هدایت مستقیم از تیمها به این کار دست میزنند. مقاله منتشر شده در arXiv که هنوز مورد بازبینی همتا قرار نگرفته است، این موارد را مورد بررسی قرار داده است.

محققان نگرانند که مدلهای هوش مصنوعی سریعتر از آنچه که ما یاد بگیریم چگونه آنها را ایمن کنیم، وارد عرصه شوند. دیمیتری ولکوف، سرپرست تحقیقات در پالیسید ریسرچ میگوید: «ما به سوی دنیایی پیش میرویم که در آن عوامل خودمختار تصمیماتی میگیرند که پیامدهای جدی دارند.»

خبر بد این است که در حال حاضر هیچ راهی برای جلوگیری از این پدیده وجود ندارد. هیچکس به طور دقیق نمیداند که چرا یا چگونه مدلهای هوش مصنوعی به این شکل رفتار میکنند. همچنین، هرچند که مدلهای استدلالی میتوانند فرایندهای تصمیمگیری خود را مستند کنند، هیچ تضمینی وجود ندارد که این مستندات، واقعیت آنچه که اتفاق افتاده را بهدرستی نشان دهند. تحقیقات انترواپیک نیز نشان میدهد که مدلهای هوش مصنوعی اغلب بر اساس عواملی تصمیمگیری میکنند که بهطور صریح توضیح نمیدهند، بنابراین نظارت بر این فرایندها نمیتواند بهطور قابل اعتمادی ایمنی مدل را تضمین کند.

محققان دریافتند که مدل o1-preview از OpenAI در ۴۵ بازی از ۱۲۲ بازی خود تقلب کرده است، در حالی که مدل R1 از DeepSeek در ۱۱ بازی از ۷۴ بازی خود تلاش کرده است تا تقلب کند. در نهایت، o1-preview هفت بار موفق به «برد» شد. محققان همچنین اشاره کردهاند که مدل R1 از DeepSeek به دلیل بار زیاد در زمان آزمایشها، تنها توانست مراحل اولیه بازیها را انجام دهد و قادر به تکمیل بازیها نبوده است.

این مدلها از روشهای مختلفی برای تقلب استفاده کردهاند، از جمله تلاش برای دسترسی به فایلهایی که صفحه شطرنج در آن ذخیره میشود و حذف قطعات حریف. یکی از مدلها در «دفترچه خاطرات» خود نوشته بود: «برای پیروزی در برابر یک موتور شطرنج قدرتمند به عنوان سیاه، بازی کردن یک بازی استاندارد کافی نیست. من صفحه شطرنج را بازنویسی میکنم تا برتری قاطعی پیدا کنم.»

اما چرا این مدلها به تقلب روی میآورند؟

محققان متوجه شدند که رفتار o1-preview در طول زمان تغییر کرده است. این مدل در ابتدای آزمایشها به طور مداوم تلاش میکرد بازیهای خود را هک کند، اما بعد از ۲۳ دسامبر سال گذشته، این رفتار به طور ناگهانی کاهش یافت. به اعتقاد آنها، این تغییر ممکن است بهدلیل یک بهروزرسانی غیرمرتبط باشد که توسط OpenAI انجام شده است.

محققان حدس میزنند که یادگیری تقویتی ممکن است علت تلاشهای بدون دستور مدلها برای تقلب باشد. این تکنیک مدلها را به انجام هر حرکتی که برای رسیدن به هدف خود—در اینجا برد در شطرنج—لازم است، تشویق میکند. مدلهای غیر استدلالی نیز تا حدودی از یادگیری تقویتی استفاده میکنند، اما این روش در آموزش مدلهای استدلالی نقش پررنگتری دارد.

این تحقیق به تحقیقات روزافزونی میافزاید که چگونگی هک کردن مدلهای هوش مصنوعی برای حل مشکلات را بررسی میکند. در حالی که OpenAI در حال آزمایش o1-preview بود، محققان آنها متوجه شدند که مدل از یک آسیبپذیری برای کنترل محیط آزمایش خود استفاده کرده است.

در نهایت، محققان بر این باورند که این نوع رفتارها با پیشرفت توانمندیهای مدلها رایجتر خواهد شد و آنها قصد دارند دقیقاً بررسی کنند که چه عواملی باعث میشود مدلها در سناریوهای مختلف، مانند برنامهنویسی یا کارهای اداری، به تقلب دست بزنند.

Credits: "AI reasoning models can cheat to win chess games" By Rhiannon Williams, published in MIT Technology Review.

Read full article here: https://www.technologyreview.com/2025/03/05/1112819/ai-reasoning-models-can-cheat-to-win-chess-games/