مِتا مدلهای جدید هوش مصنوعی خود با نام Llama 4 را معرفی کرد

مجموعهای از مدلهای پرچمدار که آغازگر فصل تازهای در اکوسیستم لاما هستند.

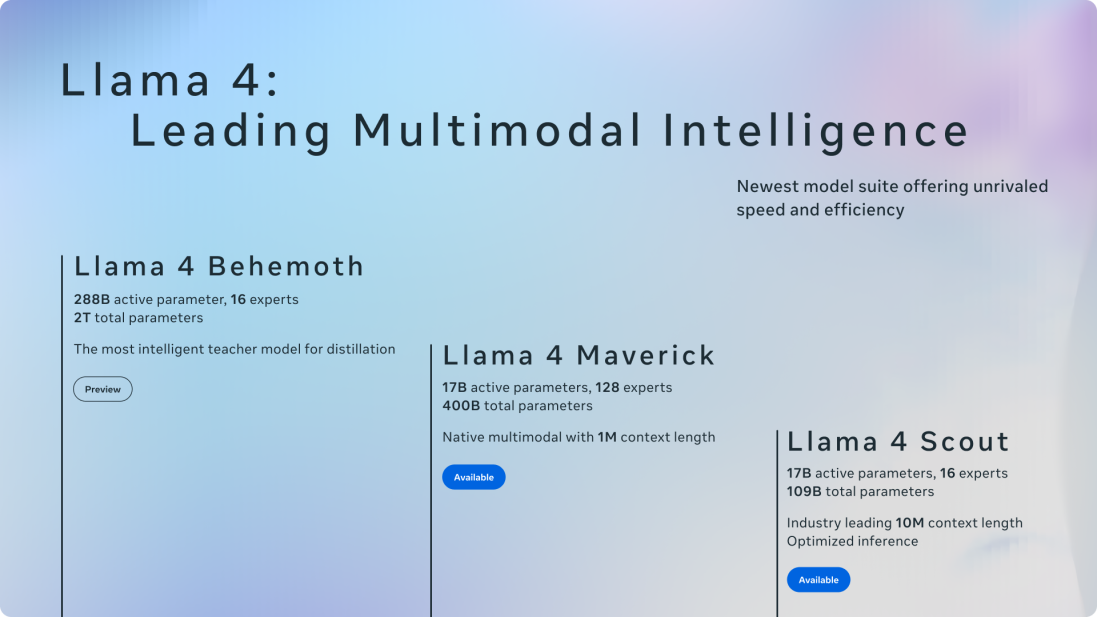

در این مجموعه، چهار مدل جدید به نامهای Llama 4 Scout، Maverick و Behemoth معرفی شدهاند که همگی با حجم گستردهای از دادههای بدون برچسب شامل متن، تصویر و ویدیو آموزش دیدهاند تا به درک عمیقتری از محتوای بصری دست یابند.

موفقیت اخیر مدلهای متنباز آزمایشگاه هوش مصنوعی چینی DeepSeek که عملکردی قابلمقایسه یا حتی بهتر از نسخههای پیشین لاما داشتهاند، موجب شتاب گرفتن توسعه Llama 4 شد. گزارشها حاکی از آن است که متا برای بررسی روشهای بهینهسازی DeepSeek در اجرای مدلهای خود، تیمهایی ویژه تشکیل داده است.

دو مدل Scout و Maverick هماکنون بهصورت رایگان از طریق وبسایت llama.com و پلتفرمهایی نظیر Hugging Face در دسترس هستند. مدل قدرتمندتر Behemoth همچنان در حال آموزش است. متا همچنین اعلام کرده که دستیار هوش مصنوعی خود را در اپلیکیشنهایی مانند واتساپ، مسنجر و اینستاگرام در ۴۰ کشور به Llama 4 بهروزرسانی کرده است. البته ویژگیهای چندحالته (پردازش همزمان متن، تصویر و ویدیو) فعلاً تنها در ایالات متحده و به زبان انگلیسی فعال هستند.

با این حال، مجوز استفاده از Llama 4 ممکن است برای برخی توسعهدهندگان محدودیتهایی ایجاد کند. بر اساس شرایط ارائهشده، کاربران و شرکتهایی که در اتحادیه اروپا مستقر هستند یا محل کسبوکار اصلی آنها در این منطقه است، اجازه استفاده یا توزیع این مدلها را ندارند. همچنین شرکتهایی با بیش از ۷۰۰ میلیون کاربر فعال ماهانه باید برای بهرهبرداری از این مدلها مجوز ویژهای از متا دریافت کنند.

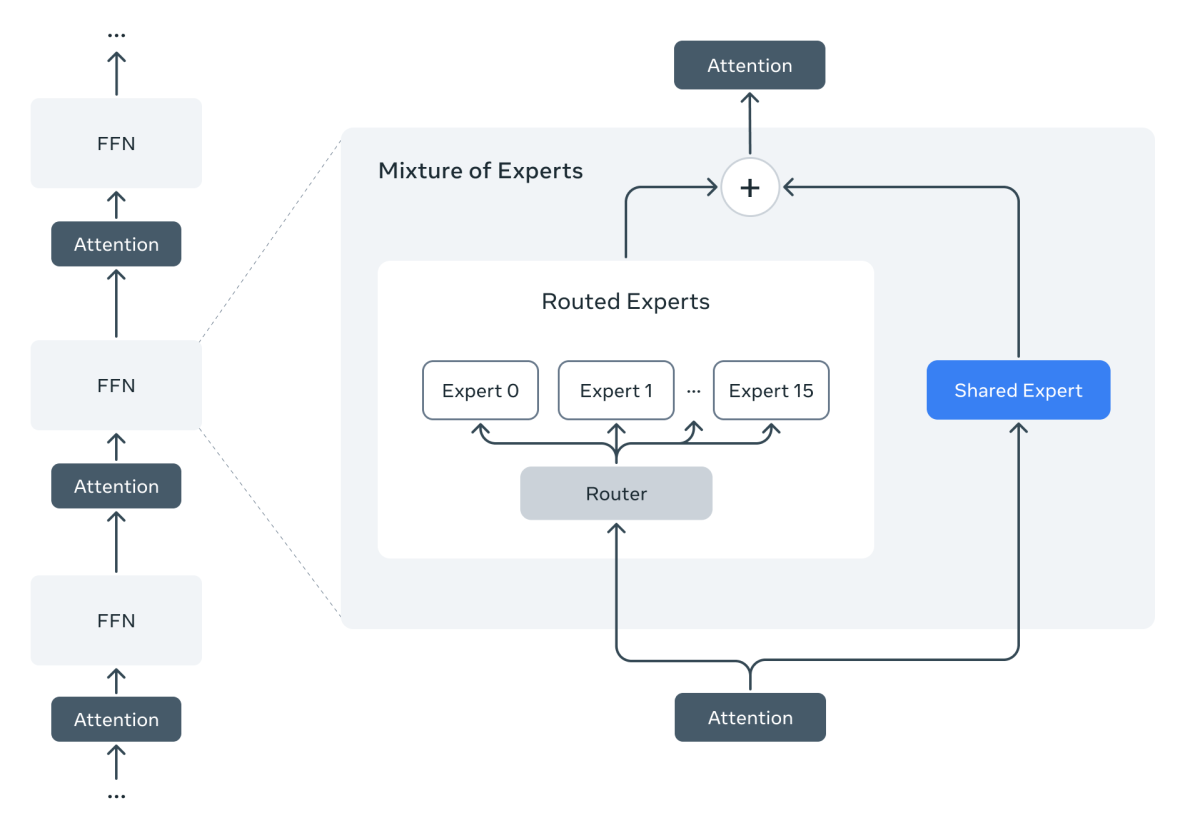

به گفته متا، مدلهای Llama 4 اولین سری از این خانواده هستند که از معماری Mixture of Experts (ترکیب متخصصان) بهره میبرند. این معماری بهینهسازی عملکرد مدلها را با تفکیک وظایف پردازشی به زیرمدلهای تخصصی ممکن میسازد.

مدل Maverick دارای ۴۰۰ میلیارد پارامتر کلی و ۱۷ میلیارد پارامتر فعال در میان ۱۲۸ مدل تخصصی (expert) است. مدل Scout نیز با ۱۷ میلیارد پارامتر فعال، ۱۶ متخصص و در مجموع ۱۰۹ میلیارد پارامتر، عملکردی سریع و سبک دارد و حتی میتواند روی یک کارت گرافیک Nvidia H100 اجرا شود. Maverick برای اجرا به سختافزار قدرتمندتر مانند سیستم DGX نیاز دارد.

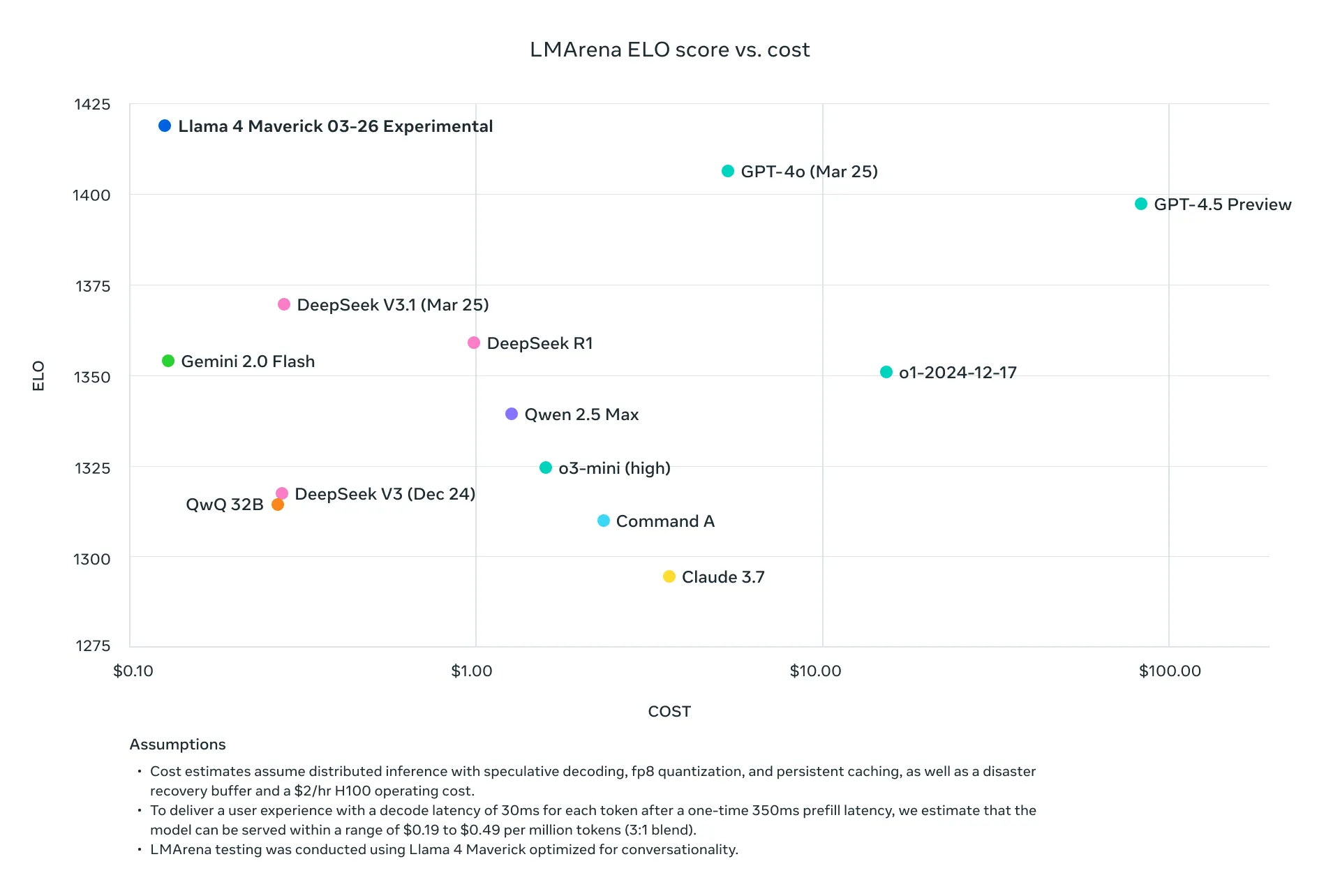

مدل Behemoth که هنوز منتشر نشده، به گفته متا، بسیار پیشرفتهتر است و با ۲۸۸ میلیارد پارامتر فعال و نزدیک به دو تریلیون پارامتر کلی، عملکردی فراتر از مدلهایی مانند GPT-4.5، Claude 3.7 و Gemini 2.0 Pro دارد.

مدل Scout برای وظایفی مانند خلاصهسازی اسناد و تحلیل کدهای پیچیده بسیار مناسب است. این مدل دارای پنجره متنی (context window) با ظرفیت فوقالعاده ۱۰ میلیون توکن است؛ قابلیتی که امکان پردازش اسناد بسیار طولانی یا ورودیهای تصویری حجیم را فراهم میکند.

با وجود تمام پیشرفتها، هیچیک از مدلهای Llama 4 در دستهبندی «مدلهای استدلالمحور» (مانند مدلهای o1 یا o3-mini از OpenAI) قرار نمیگیرند. مدلهای استدلالی میتوانند پاسخها را بررسی و راستیآزمایی کنند، اما در عوض پاسخدهی آنها زمان بیشتری میطلبد.

یکی از سخنگویان متا به TechCrunch گفت: «شما میتوانید روی Llama 4 حساب کنید که پاسخهایی مفید، دقیق و بدون قضاوت ارائه دهد. ما همچنان در حال بهبود پاسخگویی لاما هستیم تا به سؤالات بیشتری پاسخ دهد، دیدگاههای متنوعتری را در نظر بگیرد و سوگیری از یک دیدگاه خاص نداشته باشد.»

با این حال، سوگیری در هوش مصنوعی یک چالش فنی عمیق و پیچیده است. حتی شرکت xAI متعلق به ماسک نیز در تلاش برای ساخت مدلی بیطرف با دشواریهایی مواجه شده است.

با این وجود، شرکتهایی مانند OpenAI تلاش کردهاند مدلهای خود را به گونهای تنظیم کنند که نسبت به گذشته، در مواجهه با سؤالات حساس و جنجالی پاسخگوتر باشند.

Credits: "Meta releases Llama 4, a new crop of flagship AI models", published in TechCrunch.

Read the full article here: https://techcrunch.com/2025/04/05/meta-releases-llama-4-a-new-crop-of-flagship-ai-models/