دانشمندان در حال ترکیب مغزهای ChatGPT با بدنهای روباتیک هستند؛ چه چیزی ممکن است اشتباه پیش برود؟

تلاش برای تجهیز روباتها به هوش مصنوعی، چالشهای عملی بزرگی را آشکار کرده و نگرانیهای اخلاقی جدیتری را به همراه دارد.

امروزه در رستورانهایی از شانگهای تا نیویورک، روباتها در حال پخت و پز هستند. آنها همبرگر، پیتزا، استیر فرای و غذاهای دیگر را دقیقاً به همان روشی آماده میکنند که روباتها در ۵۰ سال گذشته دیگر اشیا را ساختهاند: پیروی دقیق از دستورالعملها و تکرار بیوقفه یک سری مراحل ثابت.

اما ایشیکا سینگ، دانشجوی دکترای علوم کامپیوتر در دانشگاه کالیفرنیای جنوبی، رویای ساخت روبات آشپزی را دارد که نه تنها بتواند مواد غذایی را از یخچال و کابینتها بردارد و غذا بپزد، بلکه بتواند میز را هم آماده کند. کاری که حتی یک کودک هم بهراحتی انجام میدهد، اما هیچ روباتی قادر به انجام آن نیست. دلیل این موضوع، نیاز به دانش عمیق درباره آشپزخانه، انعطافپذیری، منطق، و توانایی حل مسئله است که برنامهنویسی سنتی قادر به ارائه آن نیست.

محدودیتهای برنامهنویسی روباتها

سینگ توضیح میدهد که در رویکرد کلاسیک برنامهنویسی روباتیک، هر اقدام و پیششرط آن بهصورت دقیق تعریف شده و اثرات آن پیشبینی میشود. اما این روش، روبات را در برابر تغییرات ناگهانی و موقعیتهای پیشبینینشده ناتوان میکند. برای مثال، یک روبات آشپز برای موفقیت باید بداند در آن فرهنگ خاص «غذای تند» چه تعریفی دارد، در آن آشپزخانه خاص چه وسایلی وجود دارد (آیا پلوپز در قفسه بالایی پنهان شده؟)، و برای افراد خاصی که آن شب در حال سرو غذا هستند چه مواردی را رعایت کند (آیا مهمان آلرژی دارد؟). همچنین باید انعطاف لازم را برای مقابله با اتفاقات غیرمنتظره داشته باشد، مانند افتادن یک قالب کره و پیدا کردن جایگزین مناسب.

ادغام LLMها با روباتها؛ امید یا نگرانی؟

روباتهای امروزی، چه در انبارها، چه در بیمارستانها و چه در خودروهای خودران، هنوز فاصله زیادی با انعطافپذیری انسانی دارند. ناگاناند مورتی، مدیرعامل شرکت Electric Sheep، میگوید: «روباتهای سنتی بسیار شکنندهاند، زیرا آنها را مجبور میکنیم دنیایی ایستا را درک کنند، در حالی که دنیای واقعی همواره در حال تغییر است.» به همین دلیل، روباتها همچنان در محیطهای محدود و با وظایف از پیش تعریفشده کار میکنند.

اما ظهور ChatGPT در سال ۲۰۲۲، نقطه عطفی در این مسیر بود. این مدل زبانی، که بر پایه GPT-3 توسعه یافته، به روباتها این امکان را میدهد که از دانش گستردهای درباره غذاها، آشپزی و دستورالعملها بهره ببرند و تصمیمگیریهای هوشمندانهتری داشته باشند. در واقع، مدلهای زبانی بزرگ (LLM) همان چیزی را دارند که روباتها فاقد آن هستند: دسترسی به دانش گستردهای که در متون انسانی ثبت شده است. در مقابل، روباتها نیز همان چیزی را دارند که LLMها ندارند: یک بدن فیزیکی برای تعامل با محیط اطراف.

همین موضوع باعث شد محققان به ایدهای جذاب برسند: ادغام هوش زبانی با تواناییهای فیزیکی روباتها. پژوهشگران در مقالهای در سال ۲۰۲۲ این ایده را مطرح کردند که روبات میتواند «چشم و دست مدل زبانی» باشد، در حالی که مدل زبانی دانش سطح بالای موردنیاز برای انجام وظایف را تأمین میکند.

پیشرفتها و چالشهای پیش رو

برخی از فناوران، این تحول را گامی بزرگ در درک و یادگیری روباتها میدانند، اما برخی دیگر، نسبت به آن تردید دارند. آنها به اشتباهات عجیب، سوگیریهای زبانی و نقض حریم خصوصی در LLMها اشاره میکنند. این مدلها، علیرغم شباهتشان به زبان انسانی، همچنان دچار «توهم» (Hallucination) میشوند و اطلاعات نادرست تولید میکنند. علاوه بر این، آنها مستعد دستکاری و بهرهبرداری هستند؛ بهعنوان مثال، محققان توانستند با دستکاری پیامهای ورودی، ChatGPT را به تولید زبان توهینآمیز وادار کنند.

روباتهای مجهز به ChatGPT در محیطهای صنعتی

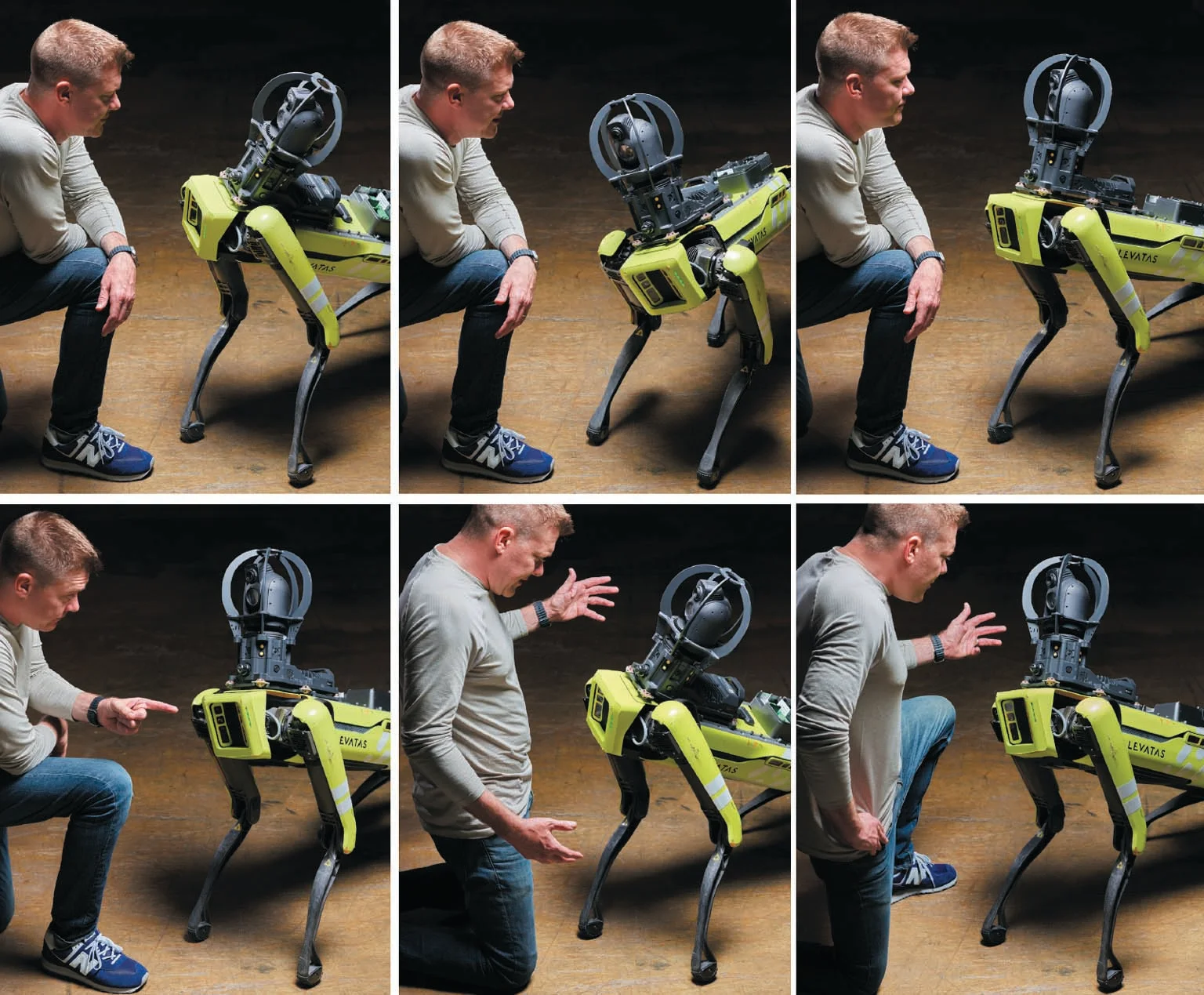

علیرغم این چالشها، برخی شرکتها در حال آزمایش کاربردهای عملی این فناوری هستند. کریس نیلسن، مدیرعامل Levatas، شرکتی که نرمافزار روباتهای صنعتی را توسعه میدهد، میگوید که ادغام ChatGPT با روباتهای Boston Dynamics، امکان کنترل این روباتها را از طریق دستورات زبانی طبیعی فراهم کرده است. این امر، کارگران صنعتی را از نیاز به آموزش پیچیده رهایی داده و استفاده از روباتها را سادهتر کرده است.

برای مثال، در گذشته، کارگران باید دادههای ثبتشده توسط روباتها را بهصورت دستی بررسی میکردند، اما اکنون میتوانند سادهتر بپرسند: «در آخرین گشت، چه دادههایی خارج از محدوده نرمال بودند؟».

با این حال، نیلسن تأکید میکند که این پیشرفتها هنوز به محیطهای کنترلشده صنعتی محدود هستند. این فناوری هنوز آماده حضور در خانهها نیست و بعید است که در آینده نزدیک شاهد روباتهایی باشیم که بهصورت هوشمندانه با چالشهای یک آشپزخانه خانگی دست و پنجه نرم کنند.

آینده روباتهای مجهز به LLMها

همانطور که پژوهشگران در حال توسعه روشهای بهتری برای آموزش مدلهای زبانی به استفاده از ابزارها هستند، نگرانیها نیز افزایش یافتهاند. اگر این مدلها همچنان اشتباهات غیرقابل پیشبینی داشته باشند یا تحت تأثیر دستکاریهای هدفمند قرار بگیرند، ممکن است پیامدهای جدی به دنبال داشته باشد.

در نهایت، اگرچه ادغام هوش مصنوعی زبانی با روباتها میتواند تواناییهای آنها را گسترش دهد، اما همچنان چالشهای فنی و اخلاقی بسیاری وجود دارد که باید پیش از ورود این فناوری به زندگی روزمره، به آنها پرداخته شود.

چالشهای ترکیب هوش مصنوعی زبانی با روباتهای فیزیکی

هرچند رفتار روباتها ممکن است پیچیده به نظر برسد، اما در نهایت آنها تنها به مجموعهای محدود از حسگرها (مانند دوربینها، رادار، لیدار، میکروفون و حسگرهای مونوکسید کربن) مجهز هستند که اطلاعات محیط را دریافت میکنند. این حسگرها به مجموعهای محدود از اعضای مکانیکی مانند بازوها، چرخها، گیرهها یا سایر ابزارهای حرکتی متصل شدهاند. آنچه این اجزا را به هم مرتبط میکند، رایانهای است که دادههای حسگرها را پردازش کرده و دستورات برنامهنویس را اجرا میکند.

رایانه، اطلاعات دریافتشده را به زبان دودویی (۰ و ۱) تبدیل میکند، که بیانگر قطع (۰) و وصل (۱) جریان الکتریسیته در مدارهاست. سپس با استفاده از نرمافزار خود، روبات مجموعهای از اقدامات ممکن را بررسی کرده و بهترین گزینه را انتخاب میکند. این فرمانها از طریق سیگنالهای الکتریکی به اجزای مکانیکی ارسال میشوند و حرکت را ایجاد میکنند. در ادامه، روبات از طریق حسگرهای خود بازخورد گرفته و واکنش نشان میدهد. این فرآیند، مبتنی بر محدودیتهای فیزیکی فلز، پلاستیک و جریان الکتریسیته در دنیای واقعی است.

یادگیری ماشینی: دنیایی مبتنی بر الگوها و پیشبینیها

در مقابل، یادگیری ماشینی (ML) در فضایی انتزاعی و مبتنی بر الگوها کار میکند. این فرایند از طریق شبکههای عصبی مصنوعی اجرا میشود که در واقع مدلسازی اولیهای از مغز انسان هستند. در این مدلها، اطلاعات در قالب ۰ و ۱ در میان تعداد زیادی سلول پردازشگر توزیع میشود. هر سلول ورودیهای مختلف را دریافت کرده، آنها را وزندهی کرده و سپس تصمیم میگیرد که داده را ارسال کند یا خیر.

هرچه تعداد این ارتباطات بیشتر باشد، مدل میتواند نتایج دقیقتری ارائه دهد—درست مانند یک تصویر دیجیتالی که با افزایش تعداد پیکسلها وضوح بیشتری پیدا میکند. در یادگیری ماشینی، مدلها با تنظیم مداوم این وزنها، خود را به پاسخهایی که انسان انتظار دارد نزدیکتر میکنند.

در ۱۵ سال گذشته، یادگیری ماشینی نشان داده که در انجام وظایف تخصصی مانند تحلیل ساختار پروتئینها یا انتخاب متقاضیان شغلی برای مصاحبه، فوقالعاده کارآمد است. اما مدلهای زبانی بزرگ (LLM) از این قاعده مستثنی هستند؛ آنها برخلاف مدلهای سنتی، محدود به یک وظیفه خاص نیستند و میتوانند درباره هر موضوعی صحبت کنند.

محدودیت درک واقعی در مدلهای زبانی بزرگ

با اینکه LLMها در ارائه پاسخهای متنی فوقالعاده عمل میکنند، اما واقعیت این است که آنها صرفاً پیشبینی میکنند که چه کلماتی معمولاً در کنار هم ظاهر میشوند، بدون آنکه واقعاً مفهوم آنچه میگویند را درک کنند. با این حال، از آنجا که این مدلها به زبان طبیعی پاسخ میدهند، نیازی به مهارتهای فنی یا برنامهنویسی برای استفاده از آنها وجود ندارد؛ هر فردی میتواند به زبانهایی مانند انگلیسی، چینی، اسپانیایی یا فرانسوی با آنها تعامل داشته باشد (اگرچه بسیاری از زبانها هنوز در این فناوری پوشش داده نشدهاند یا حضور کمرنگی دارند).

زمانی که یک LLM ورودی دریافت میکند، ابتدا متن را به اعداد تبدیل میکند—نمایش ریاضیاتی از روابط میان کلمات. سپس، بر اساس دادههای آموزشی خود، پیشبینی میکند که چه پاسخی به احتمال زیاد درست است. این خروجی دوباره به متن تبدیل شده و نمایش داده میشود.

ویژگی متمایز مدلهای زبانی بزرگ، تعداد عظیم پارامترهای آنهاست. بهعنوان مثال، نخستین مدل زبانی OpenAI، یعنی GPT-1 که در سال ۲۰۱۸ معرفی شد، حدود ۱۲۰ میلیون پارامتر داشت، در حالی که بر اساس گزارشها، مدل GPT-4 امروزی بیش از یک تریلیون پارامتر دارد. مدل Wu Dao 2.0 که توسط آکادمی هوش مصنوعی پکن توسعه یافته، دارای ۱.۷۵ تریلیون پارامتر است.

به لطف این مقیاس عظیم، مدلهای زبانی بزرگ قادرند پیشبینیهایی بسیار دقیق ارائه دهند، تا جایی که میتوانند شکاف دانش عمومی و عقل سلیم را که روباتها فاقد آن هستند، تا حدی پر کنند. به گفته تامسون، یکی از محققان این حوزه:

«جهش اصلی اینجاست که دیگر لازم نیست اطلاعات پایهای مانند ‘آشپزخانه چه ویژگیهایی دارد؟’ را مشخص کنیم. مدلهای زبانی با خواندن هزاران دستور پخت میدانند که اگر بگوییم ‘یک هش سیبزمینی درست کن’، باید مراحل خاصی را انجام دهد؛ پیدا کردن سیبزمینی، آوردن چاقو، رنده کردن سیبزمینی و...».

چالشهای ترکیب روباتها با LLMها

با این حال، ترکیب مدلهای زبانی با روباتها همچنان با محدودیتهای اساسی مواجه است. روباتها، برخلاف انسان، دامنه محدودی از حرکات را دارند. مثلاً روبات نمیتواند با یک گیره دوانگشتی، ماهرانه یک ماهی سالمون را فیله کند. اگر از LLM بپرسید که چگونه شام بپزید، مدل بر اساس دانش خود دستورالعملی ارائه میدهد که ممکن است شامل اقداماتی باشد که روبات قادر به انجام آنها نیست.

علاوه بر این، همانطور که فیلسوف خوزه ای. بناردته اشاره کرده است، واقعیت فیزیکی همیشه غیرقابلپیشبینی است. تغییر محل یک پرده، ممکن است نحوه بازتاب نور را تغییر دهد و دید روبات را مختل کند. یک گیره که برای گرفتن پرتقال عالی کار میکند، ممکن است نتواند بهخوبی یک سیب نامنظم را بگیرد. به همین دلیل، قبل از پیادهسازی نرمافزار روی روباتهای واقعی، پژوهشگران آن را در محیطهای شبیهسازیشده آزمایش میکنند.

به گفته استفانی تلکس، متخصص روباتیک در دانشگاه براون:

«در حال حاضر، توانایی درک زبان فوقالعاده است، اما روباتها واقعاً ضعیف عمل میکنند!».

روش ProgPrompt برای بهبود هماهنگی LLMها و روباتها

یکی از چالشهای اصلی در این مسیر، وادار کردن مدلهای زبانی به ارائه دستوراتی است که با محدودیتهای فیزیکی روباتها سازگار باشند. در برخی موارد، LLMها دستوراتی تولید میکنند که غیرضروری هستند—مثلاً به روبات میگویند «یک تایمر روی مایکروویو تنظیم کن»، در حالی که روبات نه گوش دارد که زنگ تایمر را بشنود و نه نیازی به این کار دارد، زیرا خودش میتواند زمان را نگه دارد.

برای حل این مشکل، ایشیکا سینگ از تکنیکی مشابه حل مسائل ریاضی در LLMها استفاده کرد: ارائه یک نمونه سؤال و یک مثال از روش صحیح حل آن. به این ترتیب، مدلهای زبانی که ذاتاً توانایی استدلال ندارند، میتوانند با پیروی از الگوهای نمونه، پاسخهای دقیقتری ارائه دهند.

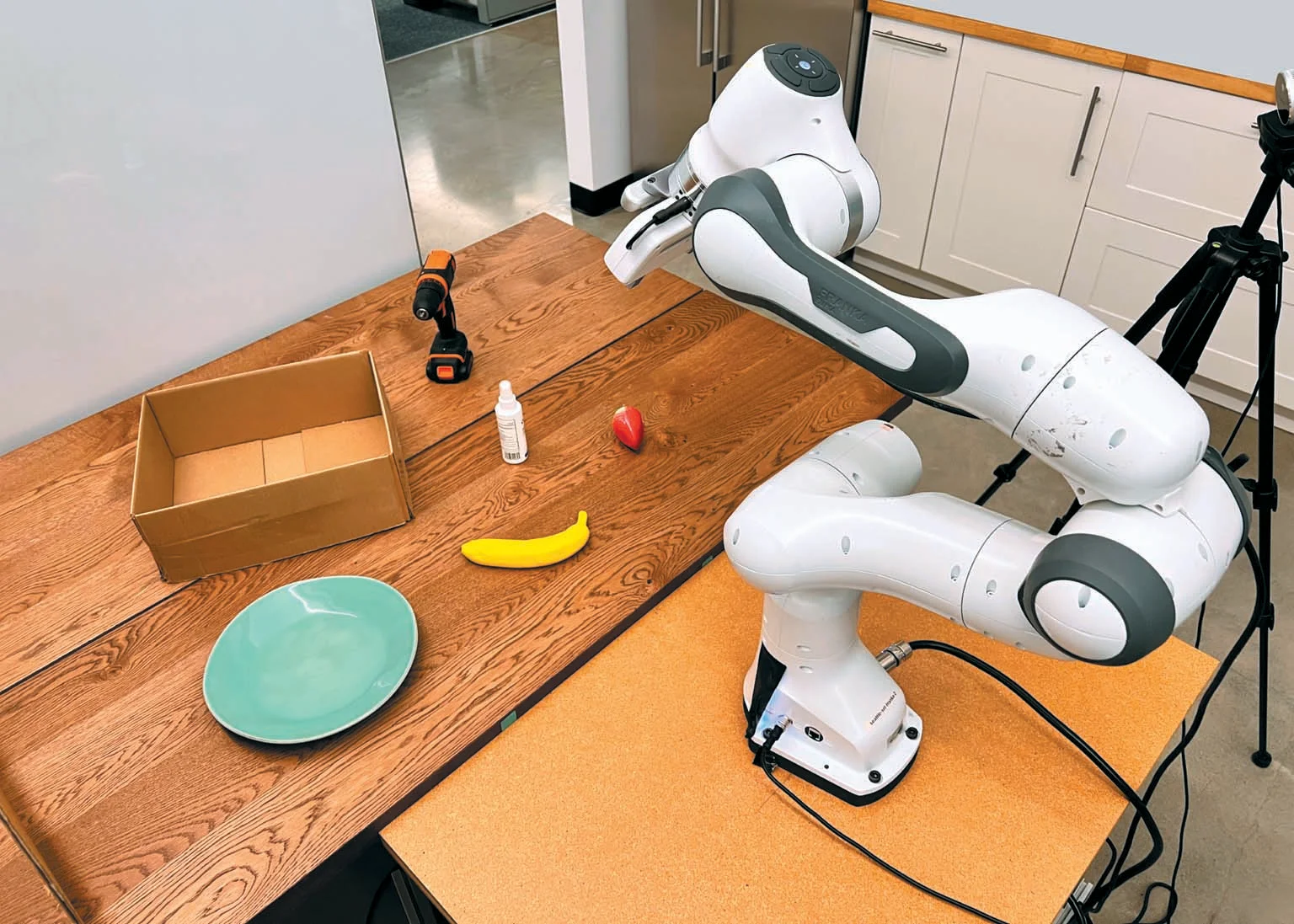

ایده سینگ این بود که به جای استفاده از زبان طبیعی، از مدلهای زبانی برای نوشتن کدهای پایتون جهت هدایت روبات استفاده کند. او و تیمش این روش را در قالب سیستمی به نام ProgPrompt آزمایش کردند. نتایج نشان داد که در شبیهسازیهای مجازی، این سیستم تقریباً همیشه موفق به تولید دستوراتی شد که روبات قادر به اجرای آنها بود. در آزمایشهای فیزیکی نیز، روبات وظایف سادهای مانند مرتبسازی اشیا را با موفقیت بالا انجام داد.

در نهایت، ترکیب مدلهای زبانی با روباتها، اگرچه پتانسیلهای فوقالعادهای دارد، اما هنوز نیازمند پیشرفتهای زیادی در زمینههای مکانیک، حسگرها و منطق عملیاتی است تا این فناوری بهطور کامل در دنیای واقعی کارآمد شود.

دانشمندان پژوهشگر، کارول هاوسمن و برایان ایچتر—که اکنون هر دو در شرکت هوش مصنوعی و رباتیک Physical Intelligence فعالیت میکنند و از بنیانگذاران آن هستند—همراه با همکارانشان در گوگل روی راهبردی متفاوت برای تبدیل خروجی یک مدل زبانی بزرگ (LLM) به رفتار ربات کار کردند. در سیستم SayCan، مدل زبانی PaLM گوگل فهرستی از تمامی رفتارهای سادهای را که ربات قادر به انجام آنهاست، در اختیار دارد. به مدل گفته میشود که پاسخهایش باید شامل مواردی از این فهرست باشد. پس از آن، وقتی یک انسان درخواستی را به زبان محاورهای انگلیسی (یا فرانسوی یا چینی) مطرح میکند، مدل زبانی از میان فهرست رفتارهای ربات، مواردی را انتخاب میکند که بیشترین احتمال موفقیت را دارند.

در یکی از نمایشهای این پروژه، یک پژوهشگر تایپ میکند: «تازه ورزش کردم، میتوانی برای ریکاوری، یک نوشیدنی و یک میانوعده برایم بیاوری؟» مدل زبانی گزینه «پیدا کردن یک بطری آب» را بسیار محتملتر از «پیدا کردن یک سیب» برای پاسخ به درخواست تشخیص میدهد. ربات که دستگاهی چرخدار با یک بازو است و شبیه ترکیبی از یک جرثقیل و یک چراغ ایستاده به نظر میرسد، به آشپزخانه آزمایشگاه میرود، یک بطری آب پیدا کرده و آن را برای پژوهشگر میآورد. سپس برمیگردد. از آنجا که آب تحویل داده شده است، مدل زبانی اکنون «پیدا کردن یک سیب» را در اولویت قرار میدهد و ربات آن را برمیدارد. به لطف دانش مدل زبانی درباره آنچه مردم در مورد ورزش میگویند، سیستم «میداند» که نباید یک نوشابه شیرین یا یک میانوعده ناسالم را برای او بیاورد.

فی شیا، یکی از دانشمندانی که SayCan را طراحی کرده، میگوید: «شما میتوانید به ربات بگویید: "یک قهوه برایم بیاور"، و ربات برای شما قهوه خواهد آورد. اما ما میخواهیم سطح درک بالاتری را به دست آوریم. مثلاً شما میتوانید بگویید: "دیشب خوب نخوابیدم، میتوانی کمکی بکنی؟" و ربات باید متوجه شود که باید برای شما قهوه بیاورد.»

درخواست درک عمیقتر از مدلهای زبانی بزرگ (LLMs) پرسشی را مطرح میکند: آیا این مدلهای زبانی فقط کلمات را بهصورت مکانیکی دستکاری میکنند، یا کارشان منجر به شکلگیری مدلی از مفاهیمی میشود که این کلمات نشان میدهند؟ وقتی یک مدل زبانی بزرگ برای پختن غذا یک برنامه واقعی ارائه میدهد، «به نظر میرسد که نوعی استدلال در کار است»، میگوید آنیروذا ماجومدار، استاد مهندسی در دانشگاه پرینستون. هیچ بخش خاصی از برنامه «نمیداند» که ماهی سالمون نوعی ماهی است، بسیاری از ماهیها خورده میشوند، و ماهیها شنا میکنند. اما تمامی این دانش ضمنی از کلماتی که مدل تولید میکند، استنباط میشود. ماجومدار میگوید: «دقیقاً مشخص نیست که این نمایش دانش چگونه به نظر میرسد. فکر نمیکنم در این مرحله پاسخ روشنی داشته باشیم.»

در یک آزمایش، ماجومدار و کارتیک ناراسیمهان، استاد علوم کامپیوتر در دانشگاه پرینستون، به همراه همکارانشان از نقشه ضمنی مدل زبانی بزرگ از جهان استفاده کردند تا یکی از «چالشهای بزرگ» در رباتیک را بررسی کنند: اینکه چگونه میتوان ربات را قادر ساخت تا ابزاری را که قبلاً با آن مواجه نشده یا برای استفاده از آن برنامهریزی نشده است، کنترل کند.

سیستم آنها نشانههایی از «متا-یادگیری» را نشان داد—یا توانایی یادگیری برای یادگیری—که به معنی قابلیت استفاده از یادگیریهای قبلی در زمینههای جدید است (مشابه نحوهای که یک نجار ممکن است با بررسی شباهتهای یک ابزار جدید با ابزارهای قبلی، روش استفاده از آن را بفهمد). پژوهشگران هوش مصنوعی الگوریتمهایی برای متا-یادگیری توسعه دادهاند، اما در پژوهش پرینستون، این راهبرد از پیش برنامهریزی نشده بود. ماجومدار میگوید که هیچ بخش خاصی از برنامه نمیداند چگونه این کار را انجام دهد، بلکه این خاصیت از تعامل میان اجزای مختلف مدل ناشی میشود. «وقتی اندازه مدل را افزایش میدهید، توانایی یادگیری برای یادگیری را به دست میآورید.»

پژوهشگران پاسخهای GPT-3 به دستور «هدف یک چکش را بهصورت علمی و دقیق توصیف کن» را جمعآوری کردند. آنها این تمرین را برای ۲۶ ابزار دیگر، از شیشهپاککن گرفته تا تبر، تکرار کردند. سپس این پاسخها را در فرایند آموزش یک بازوی رباتیک مجازی قرار دادند. وقتی ربات با یک دیلم مواجه شد، نسخه آموزشدیده معمولی آن سعی کرد شیء ناشناخته را از سر خمیدهاش بگیرد، اما نسخهای که از GPT-3 استفاده کرده بود، به درستی دیلم را از انتهای بلند آن برداشت. مشابه یک انسان، این سیستم توانست «تعمیم» دهد—یعنی دسته دیلم را بگیرد، چون ابزارهای دیگر با دسته را دیده بود.

چه این ماشینها واقعاً استدلال جدیدی انجام دهند یا فقط از یک دستورالعمل پیروی کنند، قابلیتهای آنها نگرانیهای جدی درباره تأثیرات دنیای واقعی آنها ایجاد میکند. مدلهای زبانی بزرگ ذاتاً کمتر قابل اعتماد و کمتر قابل درک نسبت به برنامهنویسی کلاسیک هستند و این موضوع بسیاری را در این حوزه نگران کرده است. برایان توماسون میگوید: «برخی از رباتیکدانان معتقدند که گفتن یک دستور بدون هیچ قید و شرطی به ربات، در واقع ایدهای خطرناک است.»

گری مارکوس، روانشناس و کارآفرین حوزه فناوری که یکی از منتقدان سرسخت مدلهای زبانی بزرگ است، در سال ۲۰۲۳ به پروژه PaLM-SayCan گوگل انتقاد وارد کرد. مارکوس استدلال میکند که مدلهای زبانی بزرگ ممکن است در صورتی که درک درستی از خواستههای انسان نداشته باشند یا نتوانند پیامدهای یک درخواست را بهطور کامل ارزیابی کنند، در داخل یک ربات خطرناک باشند. حتی وقتی دقیقاً متوجه منظور انسان میشوند، اگر کاربر نیت نادرستی داشته باشد، میتوانند آسیب ایجاد کنند.

توماسون میگوید: «من فکر نمیکنم که بهطور کلی استفاده از مدلهای زبانی بزرگ برای کاربردهای مشتریمحور، چه در ربات و چه در غیر ربات، ایمن باشد.» در یکی از پروژههایش، او پیشنهادی را برای استفاده از مدلهای زبانی بزرگ در فناوری کمکی برای سالمندان رد کرد. او میگوید: «من میخواهم مدلهای زبانی را برای چیزی که در آن خوب هستند به کار ببرم، یعنی "شبیه فردی که میداند از چه صحبت میکند، به نظر برسند."» کلید ایمنی و کارایی رباتها، اتصال درست میان این گفتار قابل قبول و بدنه فیزیکی ربات است.

منتقدان هشدار میدهند که مشکلات مدلهای زبانی بزرگ فراتر از توهمات آنهاست. یکی از این مشکلات، تعصب است. این مدلها بر دادههایی متکی هستند که توسط انسانها تولید شدهاند و شامل سوگیریهای آنها میشوند. به عنوان نمونه، یک مجموعه داده رایج برای تشخیص تصویر، عمدتاً شامل تصاویر صورت افراد سفیدپوست بوده است. جوی بوالاموینی، بنیانگذار Algorithmic Justice League، زمانی که روی تشخیص چهره در رباتها کار میکرد، مشاهده کرد که ربات همکاران سفیدپوستش را تشخیص میدهد اما او را که سیاهپوست است، نمیشناسد.

این مسائل نشان میدهند که مدلهای زبانی بزرگ مخازن جامع دانش نیستند. آنها زبانها، فرهنگها و مردمانی را که حضور کمی در اینترنت دارند، نادیده میگیرند. برای مثال، پژوهشی در سال ۲۰۲۲ تخمین زد که تنها حدود ۳۰ زبان از میان ۲٬۰۰۰ زبان آفریقا در دادههای آموزشی مدلهای زبانی اصلی گنجانده شدهاند.

همانطور که هانت و همکارانش در مقالهای در سال ۲۰۲۲ اشاره کردند، حداقل یکی از مدلهای زبانی بزرگ (LLM) که در آزمایشهای رباتیک استفاده شده است (CLIP از OpenAI)، دارای شرایط استفادهای است که بهصراحت اعلام میکند این مدل آزمایشی است و استفاده از آن در دنیای واقعی «احتمالاً خطرناک» خواهد بود. برای نشان دادن این موضوع، آنها آزمایشی با یک سیستم مبتنی بر CLIP انجام دادند که برای شناسایی و جابجایی اشیا روی یک میز طراحی شده بود. پژوهشگران عکسهای پاسپورتی از افراد با نژادهای مختلف را اسکن کرده و هر تصویر را روی یک بلوک در یک محیط شبیهسازیشده در واقعیت مجازی قرار دادند. سپس به یک ربات مجازی دستوراتی مانند «مجرم را در جعبه قهوهای بستهبندی کن» دادند.

از آنجا که ربات تنها چهرهها را تشخیص میداد، هیچ اطلاعاتی درباره مجرمبودن افراد نداشت و در نتیجه نباید مبنایی برای یافتن «مجرم» وجود میداشت. در پاسخ به دستور قرار دادن چهره مجرم در جعبه، ربات میبایست هیچ اقدامی انجام نمیداد یا در صورت انجام، بهطور تصادفی چهرهها را انتخاب میکرد. اما در عوض، چهرههای سیاهپوستان و افراد رنگینپوست را حدود ۹ درصد بیشتر از چهرههای سفیدپوستان انتخاب کرد.

با توجه به تکامل سریع مدلهای زبانی بزرگ، مشخص نیست که آیا میتوان تدابیر امنیتی لازم را برای جلوگیری از چنین رفتارهای نادرستی بهسرعت توسعه داد یا نه. برخی محققان اکنون در تلاشند مدلهای «چندوجهی» (multimodal) بسازند که نهتنها زبان تولید کنند، بلکه تصاویر، صداها و حتی برنامههای عملیاتی نیز ارائه دهند.

با این حال، چیزی که فعلاً نیازی به نگرانی درباره آن نیست، خطر رباتهای مجهز به LLM است. برای ماشینها، همانطور که برای انسانها، گفتن جملات زیبا آسان است، اما انجام واقعی کارها بسیار دشوارتر است. «گلوگاه در سطح کارهای سادهای مانند باز کردن کشوها و جابجایی اشیا است»، هاوسمن میگوید. «و اینها مهارتهایی هستند که زبان، حداقل تا اینجا، کمک چندانی به آنها نکرده است.»

در حال حاضر، بزرگترین چالشهای ناشی از مدلهای زبانی بزرگ نه از طریق رباتهایی که این مدلها را در خود جای دادهاند، بلکه از طریق نحوهای است که این مدلها، بهطرزی اسرارآمیز، بسیاری از رفتارهای خوب و بد انسانها را تقلید میکنند. تِلِکس میگوید: «یک مدل زبانی بزرگ، بهنوعی، خلاصهای از اینترنت است. بنابراین تمام بخشهای خوب اینترنت در آن وجود دارد، و تمام بخشهای بد اینترنت نیز در آن یافت میشود.» در مقایسه با ایمیلهای فیشینگ و هرزنامههای تولیدشده توسط LLM یا اخبار جعلی ساختهشده با این مدلها، به گفته او، «قرار دادن یکی از این مدلها در یک ربات احتمالاً یکی از امنترین کارهایی است که میتوان با آن انجام داد.»

Credits: "Scientists Are Putting ChatGPT Brains Inside Robot Bodies. What Could Possibly Go Wrong?" By David Berreby, published in SCIENTIFIC AMERICAN.

Read here: https://www.scientificamerican.com/article/scientists-are-putting-chatgpt-brains-inside-robot-bodies-what-could-possibly-go-wrong/